このガイドでは、以下の点を理解できます:

- 世界がジェネレーティブAIを超えて、能動的AIの時代へと移行している理由。

- 現在の大規模言語モデルの最大の制約点。

- これらの限界をエージェント型ナレッジパイプラインでどう克服するか。

- AIエージェントが失敗する場面とその理由、成功に必要な要素

- Bright Dataが提供するAIエージェントをマスターするための包括的なツール群

さあ、始めましょう!

エージェント型AIの時代:生成AIからAIエージェントへ

マッキンゼーによると、調査対象企業の約88%が少なくとも1つの業務機能でAIを活用している。さらに興味深いことに、回答者の23%は自社組織が既に企業内のどこかでエージェント型AIシステムの拡大を進めており、別の39%がAIエージェントの積極的な実験を行っていると回答している。

これは単純な生成AIパイプラインから、より高度なエージェントベースシステムへの漸進的な移行を示しています。企業はもはやモデルにプロンプトを与えるだけではありません。実際のプロセスやシステム内でAIエージェントをテストしているのです。

その理由は?従来の汎用AIワークフローと比べ、AIエージェントは自律性を持ち、エラーからの回復が可能で、はるかに複雑な目標を追求できるからだ。これこそが、AIを活用した意思決定と、より深く実用的なインサイトの真の鍵となる。

この転換は成果を上げつつある。PwCが300人の上級管理職を対象に行った調査では、3分の2(66%)がAIエージェントが主に生産性向上を通じて測定可能な価値を提供していると報告している。

当然ながら、エージェント型AIはこの分野で最も急成長しているトレンドの一つであり続けています。フォーブスは、エージェント型AI市場が2026年の85億ドルから2030年までに450億ドルに成長すると予測しており、このパラダイムがどれほど急速に普及しつつあるかを裏付けています。

AIエージェントの最大の限界

「エージェント型AI」とは、AIエージェントを介したAI活用を指す。これらは計画・推論・行動を自律的に実行し、最小限の人間介入または完全な代行により特定目標を達成するよう設計されたシステムである。

その仕組みは?明確な指示、ツール統合、オプションの人間介入ステップ、試行錯誤による実行で構成されるタスクベースのロードマップに従う。詳細はAIエージェント構築ガイドを参照のこと。

エージェント型AIシステムは、特定のタスクに特化した複数の基盤AIエージェントに依存することも可能です。これは強力に聞こえますが、実際その通りです。ただし、あらゆるAIエージェントの頭脳と主エンジンは依然として大規模言語モデル(LLM)であることを忘れてはなりません。

LLMは私たちの働き方や複雑な問題へのアプローチを変革しましたが、いくつかの限界も伴います。最も重要な2点は以下の通りです:

- 知識の限界:LLMの知識は過去の断片を示すトレーニングデータに制約されます。そのため、明示的に更新または拡張されない限り、現在の出来事や最近の変化を認識できません。正しい答えを推測することもありますが、自信を持って誤った回答や幻覚的な応答を生成することもあります。

- 現実世界との直接的な相互作用の欠如:LLMは専用のツールや統合なしに、インターネット、外部システム、ライブ環境と相互作用できません。その主な機能は、既知の情報と要求された内容に基づいて、テキスト、画像、コード、動画などのコンテンツを生成することです。

AIエージェントはLLMの上に構築されるため、選択するエージェント型AIフレームワークに関わらず、これらの制約を継承します。そのため、適切なアーキテクチャと制御がなければ、全てのAIエージェントが意図した通りに動作するとは限りません。

解決策は「エージェント型ナレッジパイプライン」

お気づきかもしれませんが、エージェント型AIの固有の限界を克服する最も簡単かつ効果的な方法は、AIエージェントに適切なツールを装備することです。これらのツールは、ライブデータの検索・取得、現実世界との相互作用、そしてエージェントが操作する対象となるシステムやサービスとの統合を可能にするものでなければなりません。

とはいえ、単にエージェントにツールを与えるだけでは不十分です。エージェントを生産的で高速かつ信頼性の高いものにするために、その論理フローを構造化することも同様に重要です。したがって、これらのツールの入手先や仕組みについて掘り下げる前に、成功するAIエージェントがどのように高レベルで動作するのかを見てみましょう!

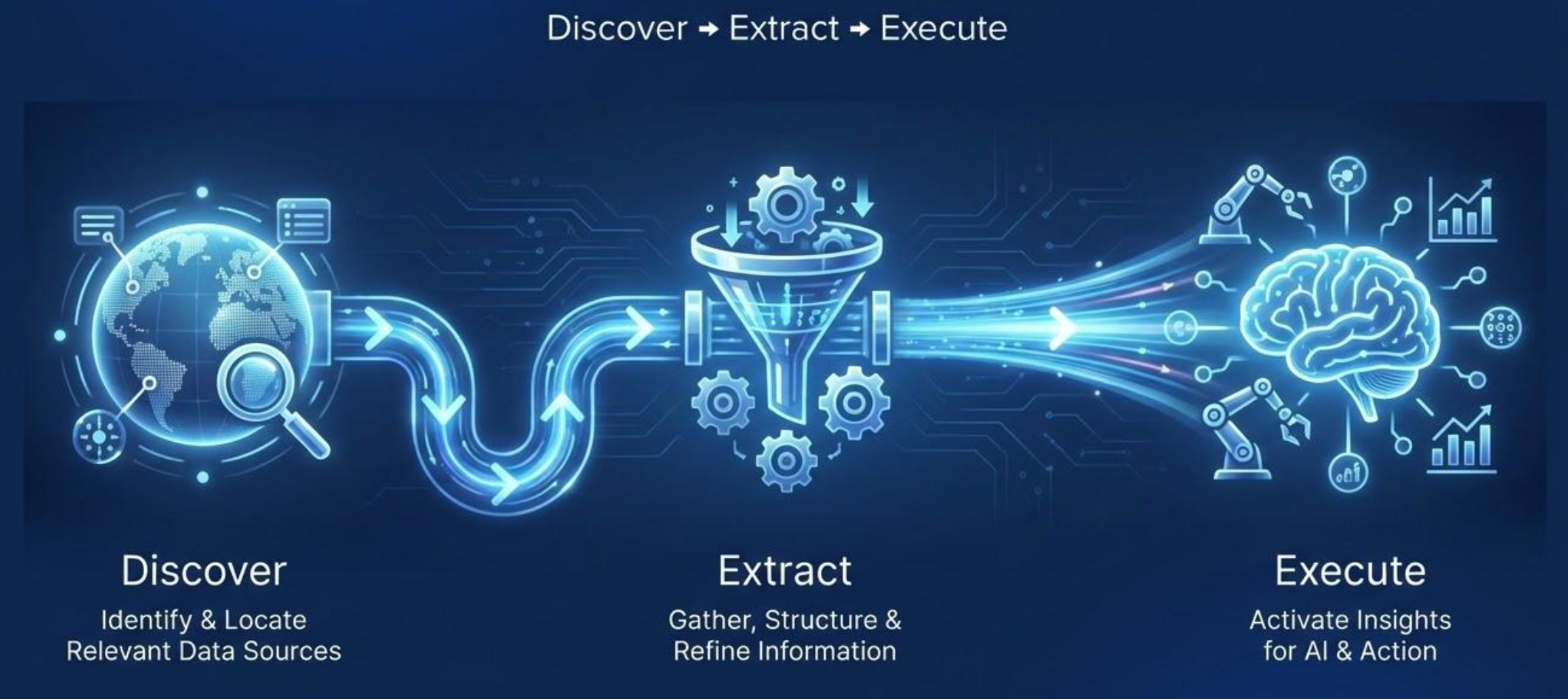

エージェント知識パイプライン:発見、抽出、実行

人間が最良の結果を達成する方法を考えてみましょう。適切な情報とツールにアクセスでき、それらを賢く活用する方法を知っているとき、私たちはより優れたパフォーマンスを発揮します。同じ原理がAIエージェントにも適用されます。

信頼性の低い動作や不十分な結果を避けるため、エージェント型AIシステムはリアルタイムで検証可能かつ正確な知識へのアクセスを必要とします。その知識は適切なツールを通じて外部世界と対話するために活用されます。

直感的に理解できるように、確固として実用的なエージェント型AIシステムは「エージェント知識パイプライン」に従います。これは3つの核心的段階で構成されます:

- 発見: 目の前のタスクに基づき、関連するデータソースを特定・位置特定する。目的は、エージェントの意思決定に情報を提供できる信頼性が高く最新のソースを見つけることである。

- 抽出:データを取得し、利用可能な知識に変換する。これには情報の収集、ノイズの除去とフィルタリング、非構造化データの構造化、結果を一貫したデータ形式(例:Markdown、プレーンテキスト、JSONなど)に集約し、エージェントが推論できるようにすることが含まれる。

- 実行:獲得した知識を活用して意思決定と行動を推進する。これには、洞察の生成、ワークフローの起動、または意図した目的を達成するためのウェブサイトとの対話などが含まれる。

重要:最初の2段階は一般的に「エージェント知識獲得」フェーズと呼ばれる。ほとんどのアプリケーションやユースケースにおいて、これらが最も重要な段階である(そして後述するように、ここで問題が発生しやすい)。

エージェント的知識獲得フェーズでは、システムはタスクに最も関連性の高いデータを検索、取得、精緻化します。これは通常、複数のAIエージェントを調整して的を射た信頼性の高い情報取得を保証する専用のエージェント的RAGシステムによって実現されます。最後に、エージェント的システムは先に収集したコンテキストと知識に基づいて行動を起こします。

AIエージェントがエージェント型知識パイプラインを辿る方法

ほとんどの状況において、AIエージェントは高度な自律性と推論能力を有していることを念頭に置いてください。したがって、彼らが常に厳密に直線的な方法でパイプラインに従うとは限りません。代わりに、個々の段階をループしたり、時には3段階すべてをループしたりすることが一般的です。

例えば、第一段階で発見されたデータが不十分または低品質と判断された場合、エージェントは追加検索を実行する可能性があります。同様に、実行段階の結果が不満足な場合、エージェントは最初に戻りアプローチを洗練させることを決定できます。これは高品質な成果を追求する人間の働き方を反映しています。

したがって、エージェント型知識パイプラインは(静的にコーディングされた汎用AIパイプラインで見られるような)「発見」から「実行」への直線的な流れではありません。同時に、この人間のような反復的行動を手動で管理する必要もありません。AIエージェントフレームワークやライブラリが自動的に処理してくれます!

サポートされるユースケース

継続的な知識獲得によって駆動されるエージェント型AIシステムは、動作が必要な特定の文脈に深く根ざします。この状況認識能力により、以下のような幅広いシナリオをカバーできます:

| ユースケース | 説明 |

|---|---|

| エージェント型エンリッチメント | 個人、企業、製品のプロフィールを大規模かつ高精度で強化します。 |

| 代替データ | エージェントが継続的にロングテール市場シグナルを収集・検証し、標準的な情報源を超えた洞察を提供します。 |

| 自動化された市場分析 | トレンド、価格、需要シグナルを分析し、戦略的なビジネス判断を支援します。 |

| ESG追跡 | 断片化された環境・社会・ガバナンス(ESG)データを集約し、企業のサステナビリティへの影響を透明性をもって可視化します。 |

| 知的財産とブランド保護 | 市場や登録機関をスキャンし、不正な商標使用や偽造製品を検出します。 |

| 競合情報 | 複数の情報源にわたる変化を検知し、明らかな範囲を超えたトレンドや競合他社の動きを明らかにします。 |

| 垂直検索 | ドメイン固有の情報源を定期的にクロールし、正規化して、ライブで最新のインデックスにまとめます。 |

| 規制モニタリング | 地域やセクターを横断し、規制やコンプライアンスの更新をリアルタイムで追跡します。 |

| 脅威インテリジェンス | 複数のオンライン情報源からサイバーセキュリティ脅威と新たなリスクを特定します。 |

| 詳細な調査と検証 | 文書、ウェブサイト、報告書を横断し、主張を正確に検証するための証拠を迅速に収集します。 |

| ソーシャルメディア分析 | プラットフォーム上で感情分析、新興トレンド、インフルエンサー活動を監視。 |

| コンテンツキュレーション | チーム向けに、関連する記事、論文、ニュースを発見、フィルタリング、要約します。 |

| 顧客フィードバック分析 | レビュー、アンケート、ソーシャルメディア上の言及を集約・分析し、製品改善に活用する。 |

| 特許・知的財産調査 | 業界横断的な特許、出願、知的財産活動をリアルタイムで追跡。 |

| 人材と採用に関するインサイト | 候補者の空き状況、スキル、市場動向を監視し、より賢明な採用判断を実現。 |

AIエージェントが失敗する点と成功に必要な要素

エージェント型AIの重要性と効果的なシステム構築方法を理解したところで、主要な課題と要件を検討する時が来ました。

主な課題と障壁

間違いなく、ウェブは世界で最大規模かつ最新で最も活用されているデータ源です。推定64ゼタバイト(64兆ギガバイト)もの情報量です!

知的なエージェント型AIシステムにとって、インターネットから直接データを検索・取得する以外に実質的な選択肢はありません。しかし、ウェブからのデータ抽出(ウェブスクレイピングと呼ばれる)には数多くの障壁が伴います…

ウェブサイト所有者は自社のデータの価値を十分に認識しています。そのため、情報が公開されていても、IPアドレスの制限、CAPTCHA、JavaScriptによる検証、フィンガープリント分析、その他のボット対策など、スクレイピング防止策で守られていることがよくあります。

これにより、エージェントによる知識獲得フェーズは困難を極めます。AIエージェントには、適切なウェブソースからデータを探し出し取得するだけでなく、これらの保護機能を自動的に回避し、MarkdownやJSONといったRAG対応データ形式で必要な情報にアクセスするツールが必要です。詳細については、エージェント型RAGシステム構築のチュートリアルをご覧ください。

実行フェーズも同様に複雑になり得ます。特にエージェントが特定のサイトとやり取りしたり、オンライン上でアクションを実行したりする必要がある場合です。適切なツールがなければ、AIエージェントは簡単にブロックされたり、タスクを完了できなくなったりします。

成功のための要件

AIエージェントが効果を発揮するにはウェブアクセスが必要であり、克服すべき課題があることはご理解いただけたでしょう。では、真の成功には何が必要なのでしょうか?ウェブ検索・アクセス・対話のためのツールを提供するだけでは不十分です…

有意義な結果を得るには、AIエージェントが利用するツールは安定性、拡張性、回復力を備えている必要があります。結局のところ、適切なエージェント型AI技術スタックがなければ、解決策ではなく新たな問題を生み出すリスクがあるのです。

効果的に機能するためには、エージェント型AIシステムには以下の点を保証するウェブデータ取得・対話ツールが必要です:

- 高い稼働率:基盤インフラはデータ収集・処理中の中断やエラーを防ぐため、高可用性を維持しなければならない。

- 高い成功率:ツールはウェブサイトのボット対策(アンチボット)を回避し、エージェントが検索エンジンを利用し、ウェブデータを抽出し、ページとやり取りする際にブロックされないようにする必要があります。

- 高同時実行性:多くのタスクでは複数サイトからのデータ収集や同時検索クエリの実行を伴います。スケーラブルなインフラによりエージェントは多数の要求を同時に実行でき、結果の高速化を実現します。

- 検証可能な情報:AIエージェントはGoogle、Bing、Yandex、Baiduなどの主要検索エンジンと連携すべきです。これにより、検索結果を閲覧し関連性の高いURLを追跡する人間の検索方法を再現できます。このアプローチによりデータの検証可能性が確保され、ユーザー自身が同一クエリを再現し、情報を元のページURLまで遡ることが可能となります。

- 最新かつ更新されたデータ:ウェブスクレイピングツールは、ライブデータフィードを含むあらゆるウェブページから迅速に情報を抽出できなければなりません。

- LLM対応出力:データはMarkdownやJSONなどの構造化形式で提供されるべきです。LLMに生のHTMLを供給すると精度が低下しますが、クリーンで構造化されたデータはより正確な推論と洞察を可能にします。

もちろん、プロバイダーが明確なドキュメント、迅速なサポート、AIツールとのシームレスな連携を提供しなければ、これらの要件は無意味です。市場で最高のAI対応ウェブデータインフラをお探しですか?まさにそこにBright Dataが貢献します!

Bright Dataがブロック回避と目標達成を実現するAIエージェントを支援する方法

Bright Dataは、あらゆる公開ウェブサイトからデータを発見、アクセス、抽出、相互作用するためのAI対応ツールを提供する、業界をリードするウェブデータプラットフォームです。

具体的には、包括的なサービスとソリューション群を通じてエージェント型パイプラインを支援します。これらのツールにより、AIエージェントはウェブ検索、データ収集、サイトとの大規模な対話をブロックされることなく実行可能です。さらにLangChain、LlamaIndex、CrewAI、Agno、OpenClawなど著名なAIフレームワークを含む幅広い選択肢との統合を実現します。

これら全てのソリューションは、1億5000万以上のIPアドレスを擁するプロキシネットワークを基盤とした、エンタープライズグレードで無限に拡張可能なインフラによって支えられています。プラットフォームは99.99%の成功率と99.99%の稼働率を実現。さらにBright Dataは、各ソリューション向けの包括的なドキュメントや詳細なブログ記事に加え、24時間365日のテクニカルサポートを提供しています。

これらを組み合わせることで、強力なAIエージェントやリアルタイム知識取得のためのAI駆動システムを 構築することが可能になります。それでは、Bright Dataがエージェント型知識パイプラインの各段階をどのようにサポートしているのか、見ていきましょう!

発見

Bright Dataはデータ発見段階を以下でサポートします:

- SERP API:Google、Bing、DuckDuckGo、Yandexなど、複数の検索エンジンからのリアルタイム検索結果を提供します。AIエージェントが検証可能な情報源を見つけ、文脈に沿ったURLを追跡する能力を与えます。

- Web Archive API: 複数ペタバイト規模の継続的に更新される大規模ウェブアーカイブへのフィルタリングアクセスを提供。研究やAIワークフロー向けに、過去のHTML、メディアURL、多言語コンテンツの取得をサポートします。

抽出

Bright Dataは、以下の機能でウェブデータ抽出フェーズを支えます:

- Web Unlocker API: AI駆動のフィンガープリンティング、プロキシローテーション、再試行、CAPTCHAの解決、JavaScriptレンダリングによりブロックを自動回避。大規模な公開ウェブデータをLLM最適化形式で、あらゆるウェブページから確実に提供します。

- Crawl API: 単一URLからのサイト全体クロールを自動化。URLを発見し、追跡し、静的・動的コンテンツをJSON、Markdown、HTMLなどのクリーンなAI対応形式で抽出します。

実行

Bright Dataはエージェント実行ステップを以下で強化します:

- Agent Browser: クラウドベースのAI対応ブラウザ。自律エージェントがウェブサイトをナビゲートし、クリック、フォーム入力、セッション管理、データ抽出を実行。CAPTCHAやボット対策の回避、自動スケーリングを処理。

- Web MCP:AIエージェントがクラウドブラウザ内でデータ抽出、ウェブフィード取得、ページ操作を行うための60以上のツールにアクセス可能。多数のAIソリューションとの迅速かつ簡素化された連携をサポートし、無料プランを提供。

結論

本記事では、エージェント型AIシステムが普及する理由と、その基盤となるAIエージェントが本番環境対応・信頼性・成功を実現する方法を解説しました。特に、エージェント型ナレッジパイプラインを支える適切なツール提供の重要性を確認しました。

しかし重要なのは、AIエージェントが使用できるツールだけではありません。それらのツールが価値ある形で堅牢に機能することを可能にする基盤インフラも同様に重要です。この点において、BrightDataはAI向けのエンタープライズグレードアーキテクチャを提供し、エージェント型ワークフローの全領域をサポートするソリューションを実現します。

今すぐBright Dataに登録し、エージェント対応のWebデータツールの統合を始めましょう!