本記事では以下の内容を解説します:

- データ抽出とは

- データ抽出の種類とソース

- データの抽出方法

- データ抽出がビジネスに与える効果

- 最適なデータ抽出ツール

データ抽出とは何か

データ抽出とは、ウェブ上に存在するオープンソースデータなどの情報プールから対象データを取得するプロセスです。これは「ETL」という略語で表されるプロセスの最初のステップです:

- 抽出

- 変換

- ロード

競合他社の価格情報やマーケティングデータなどの対象情報が収集されると、分析され、意思決定プロセスにおけるビジネスインテリジェンス(BI)として活用されます。これは、マーケティングキャンペーンのメッセージング方針を変更するチームリーダーなどのステークホルダーによって実行されることもあれば、競合他社のリアルタイムな価格変動に基づいて価格を更新するアルゴリズムによって実行されることもあります。

データ抽出の種類とソース

データは多種多様なソースから取得可能であり、その数は対象情報の取得手法の多様性にほぼ匹敵する。

データソースの種類

データは、顧客維持率や解約率に関する統計などの内部活動、政府データベースや公文書館、そしてウェブからも導出される。

デジタルデータソース

インターネットから収集されるデータは、個人識別情報(PII)とパスワード保護情報に分類されます。欧州の一般データ保護規則(GDPR)やカリフォルニア消費者プライバシー法(CCPA)を含む国際的なデータ規制により、これら両方の収集は違法となるため、避けるべきです。これら規制は業界標準となっており、これらに手を出すことは法的観点からも消費者視点からも企業にとって不利です。

ビジネス価値のためにデータを収集・活用できるオープンソースの場所には以下が含まれます:

- ソーシャルメディア

- 検索エンジン

- 競合他社のウェブサイト

- ディスカッションフォーラム

- 政府ウェブサイト

- 歴史的アーカイブ

- eコマースマーケットプレイス

物理的なデータソース

物理世界では、毎秒、毎日、数十億のデータポイントが生成されています。これには以下が含まれます:

- 医療記録

- 保険申込書および苦情申立書

- 住宅ローン/融資申込書

- 販売時点情報管理(POS)取引データ

- 道路上の自動車や店舗内の消費者から生成される位置情報データ

- 気象条件および自然現象に関する気象データ

データ抽出の種類

データセットには様々な種類がありますが、以下に代表的なものをいくつか挙げます:

1: 完全なデータレコード

これは通常、対象となる特定のウェブサイト上の全データポイントで構成されます。例えば、特定のeコマースマーケットプレイスにおける全ベンダー、製品、顧客レビューなどです。

二つ:差分データセット

初期収集ジョブ以降に変更または更新された値に基づいて継続的に更新されるデータセットです。これには価格、フォロワー数(ソーシャルメディア上)/従業員数、調達したシード資金などが含まれます。

三:スマートサブセット

ビジネス上の疑問の解決や意思決定の支援に役立つ、非常に具体的な情報にアクセスするためのフィルタリングを含みます。例えば、「企業Aの失敗要因は何か?」や「ベンチャーキャピタルとして付加価値を創出するために、我々はどのような異なるアプローチを取れるか?」といった問いです。関連するデータポイントとしては、環境を考慮していない企業製品に対するミレニアル世代のソーシャルメディア上のネガティブな感情が挙げられます。

四:強化データセット

これらのデータセットは、ウェブ上の複数ソースからの情報を統合するため、他のデータセットよりも高い価値を持ち、関係者が問題の全体像を把握することを可能にします。例えば、5つの異なるウェブサイトやディスカッションフォーラムからのレビューや消費者感情を相互参照することなどが挙げられます。

データの抽出方法

まず、データには主に2つのカテゴリーがあることを理解することが重要です:

非構造化データ: 最も基礎的・未加工な形態のデータ。重複エントリや破損ファイルを含み、多様なフォーマットで存在する。システムやアルゴリズムによる処理・索引付け・利用が極めて困難。

構造化データ: 最も「純粋」で「洗練された」形態のデータです 。重複や破損ファイルは排除され、全てのデータレコードが統一フォーマットに変換されています。アルゴリズムやシステムがこの種のデータをスキャン、インデックス化、分析し、価値ある出力を生成するのは非常に容易です。

構造化データ/非構造化データの抽出方法

スキルセットやリソースに応じて、構造化/非構造化データを抽出する方法は多数存在します。例えばプログラミングスキルがあれば、Pythonでカスタム収集ツールを作成できます。あるいはリレーショナルデータベース内でデータを整理・検索するためにSQL(構造化問い合わせ言語)を利用する方法もあります。

しかし、プログラミングスキルを持たないビジネスパーソンにとっては、Web Scraper APIのような完全自動化されたウェブスクレイピングソリューションを選択するのが最善でしょう。これは、非構造化ターゲットデータを自動的にクリーンアップ、マッチング、統合、処理、構造化し、チームやシステムに提供するツールです。このデータは、選択した形式(JSON、CSV、HTML、またはMicrosoft Excel)で既に構造化されており、分析の準備が整っています。

構造化/非構造化データ抽出プロセス

「プログラマー志向」の方には、Pythonウェブスクレイピングガイドをぜひご覧ください。Pythonを利用したデータ抽出の一般的な手順の概要は以下の通りです:

- ステップ1:対象とするURLを選択

- ステップ2:収集したいデータを特定する

- ステップ3:コードを記述する

- ステップ4:コードを実行してデータを抽出する

- ステップ5:必要な形式でデータを保存する

WebスクレイパーAPIのような自動化ツールの場合、プロセスは以下の通りです:

- 対象ウェブサイトを選択します。

- 収集頻度とデータ形式を選択する。

- 選択した宛先(Webhook、メール、Amazon S3、Google Cloud、Microsoft Azure、SFTP、またはAPI)にデータを配信する。

データ抽出がビジネスに与える効果

データ抽出は様々な方法でビジネスを支援します:

- ビジネスの成長– 例えば、Googleの検索トレンドを追跡して新たなユーザーニーズを特定し、そのニーズに合わせたオファーを設計します。

- 競争力の強化– 競合他社がどのチャネル(例:ソーシャルメディア)で最も注目を集めているか、またどの製品が最高のコンバージョン率を達成しているかを把握し、戦略転換を可能にします。

- マーケティングキャンペーンの最適化 – プラットフォームからのソーシャルセンチメントを活用し、キャンペーンにレスポンシブなメッセージングを組み込むことが可能です 。

- 投資インテリジェンス– 投資会社はニュース記事、世論、公開されている企業の財務活動を追跡し、特定証券の株価変動をより正確に予測できます。

データ抽出における企業の最大の課題

企業がデータ抽出を試みる際に直面する主な課題には以下が含まれる:

- プログラミングに関する技術的知識の不足、および熟練したデータ抽出要員(DevOps/IT/プログラマーなど)の人員不足。

- リアルタイムデータ収集を効果的に実施するためのハードウェア・ソフトウェアを構築・購入・維持できないこと。

- 意思決定者が競合他社や消費者の現在の活動に基づいてキャンペーンを最適化できるよう、「その瞬間の価値」を実際に生み出すスケジュールでデータを収集、整理、処理、分析できないこと。

最適なデータ抽出ツール

市場には数多くのデータ抽出ツールが存在します。ツールによって優劣があり、考慮すべき関連要素にはデータの品質、データソース、IPアドレス、ピアなどが含まれます。データ駆動型製品・サービスの長期的な価値を確保するため、合法的に取得された高品質で最新の情報が提供されていることを確認し、協力するデータプロバイダーの選択には細心の注意を払う必要があります。

Bright Dataの製品は、倫理的なデータ収集において業界をリードする基準を採用しています。当社ネットワーク内のすべてのピアは、自身の裁量で参加(オプトイン)および退出(オプトアウト)を選択できるほか、デバイスをデータ収集ネットワークに参加させることに対する完全な補償を受けられます。

当社には専任チームが常駐し、コードベースの予防策や技術的対応メカニズムを含むリアルタイムコンプライアンスを実施しています。

そして最後に、すべてのデータ収集活動は、一般データ保護規則(GDPR)やカリフォルニア消費者プライバシー法(CCPA)を含む国際的なデータ保護法に100%準拠しています。

業界をリードする企業で最も人気のある2つのツールは以下の通りです:

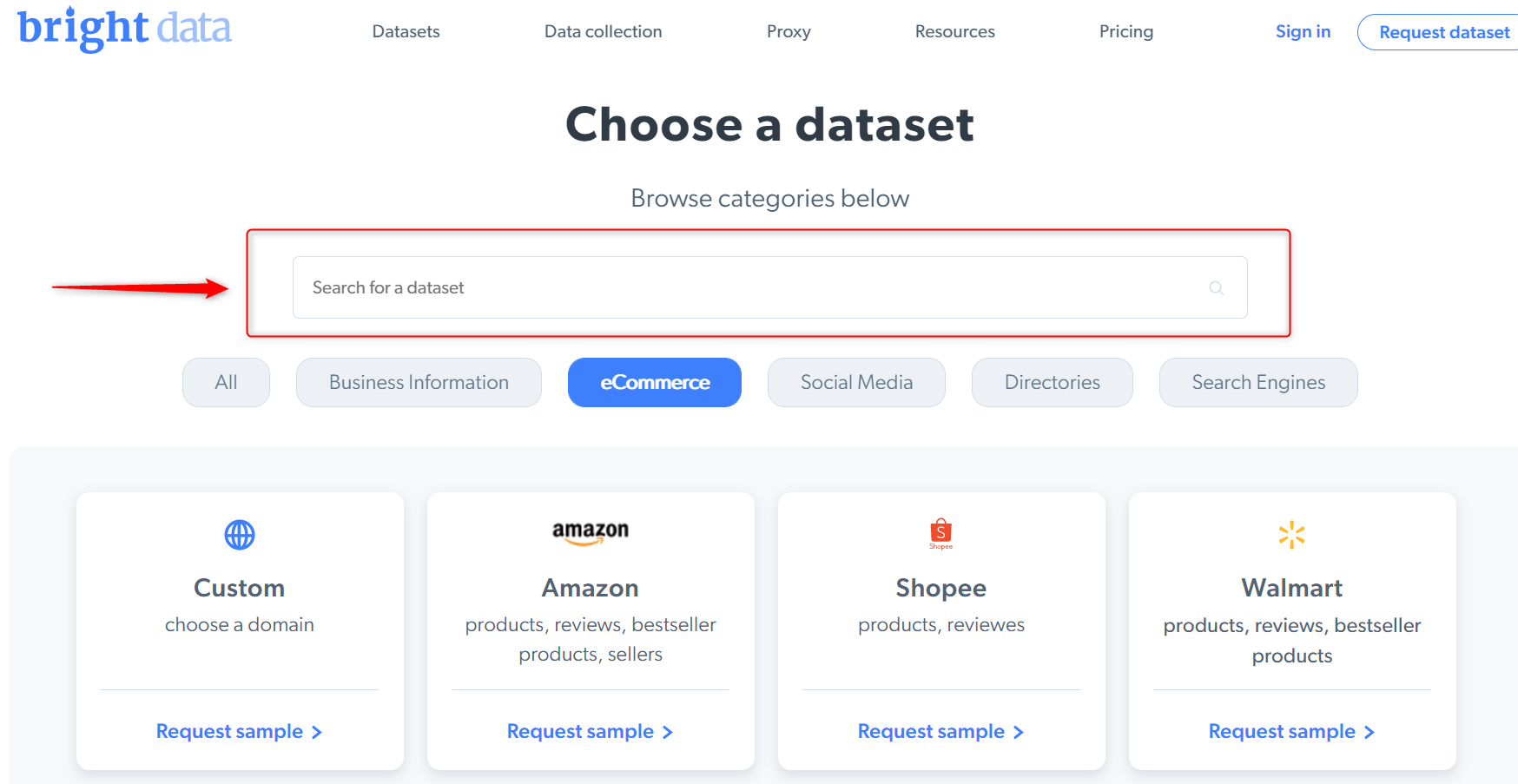

データセット

これは事前収集済みで即利用可能なデータセットであり、数分で注文・入手可能です。必要なデータセットを選択し、チーム/アルゴリズムへ直接配信されるだけです。

WebスクレイパーAPI

Web Scraper APIは、技術知識が全くないビジネスパーソンでもコーディング不要でリアルタイムデータフローにアクセスできる完全自動化ツールです。対象情報をクリーンアップ・統合し、構造化されたデータポイントを指定チームやアルゴリズムに直接配信します。

結論

データ抽出は、大規模なデータ収集・分析における主要な選択肢であり、企業や個人がサービス改善や顧客/プロジェクトの期待値理解を深める上で貢献しています。第三者の支援なしにデータ抽出を実行することは可能ですが、プロセスを外部委託することでコストと時間を節約でき、より差し迫った業務課題に注力できます。