この記事では、以下について学びます:

- ウェブサイトからスクレイピングされたデータが信頼できなかったり、古かったりする場合に開発者が直面する課題

- 悪いスクレイピング結果の原因を特定する

- よりクリーンで信頼できるデータを確保するための提案

さあ、飛び込もう!

ウェブスクレイピングデータの精度が低い原因

スクレイピングデータの精度を向上させる方法を学ぶ前に、これらの問題の原因を知る必要があります。このセクションでは、スクレイピング中に遭遇する可能性のある問題のいくつかを学びます。動的なコンテンツ、頻繁なDOMの変更などです。

JavaScriptでレンダリングされたコンテンツがデータギャップを生む

JavaScriptを多用するウェブサイトは、最初のHTMLレスポンスの後に非同期でコンテンツをロードするため、従来のHTTPスクレイパーには不完全なページ構造が残ります。ページをリクエストすると、JavaScriptが実行される前に、最初のHTMLスケルトンだけを受け取ります。eコマース・サイトの商品リスト、ソーシャル・プラットフォームのユーザー・コメント、無限スクロール・コンテンツは、通常、ページ・ロードの数ミリ秒から数秒後に発生するAJAXコールによってロードされる。

このタイミングの不一致により、スクレイパーは実際のデータの代わりにプレースホルダー要素やローディングスピナー、空のコンテナを抽出してしまいます。スクレイピングされた HTML には、入力された商品情報ではなく<div class="product-list" data-loading="true"></div> が含まれる可能性があります。

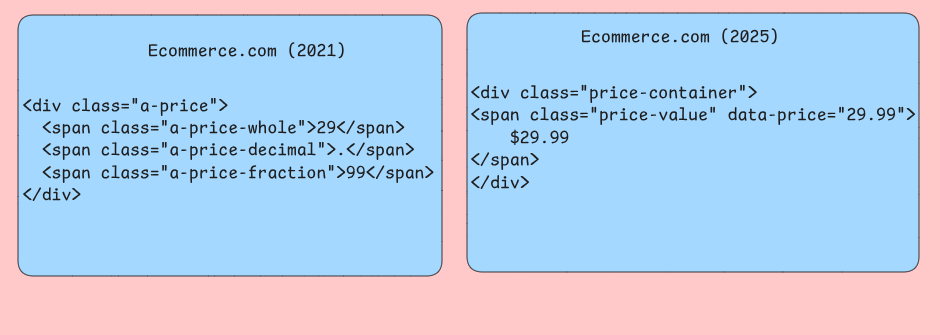

一貫性のないDOM構造の進化

ウェブサイトは、自動化ツールの後方互換性を維持することなく、HTML構造を頻繁に変更します。開発者がクラス名を変更したり、レイアウトを再構築したり、要素を別の親コンテナに移動したりすると、何カ月も確実に機能していたCSSセレクタが突然空の結果を返すことがあります。あなたのスクレイパーは、ウェブサイトの再設計中に. item-costに名前が変更された.product-priceセレクタをターゲットにしているかもしれません。

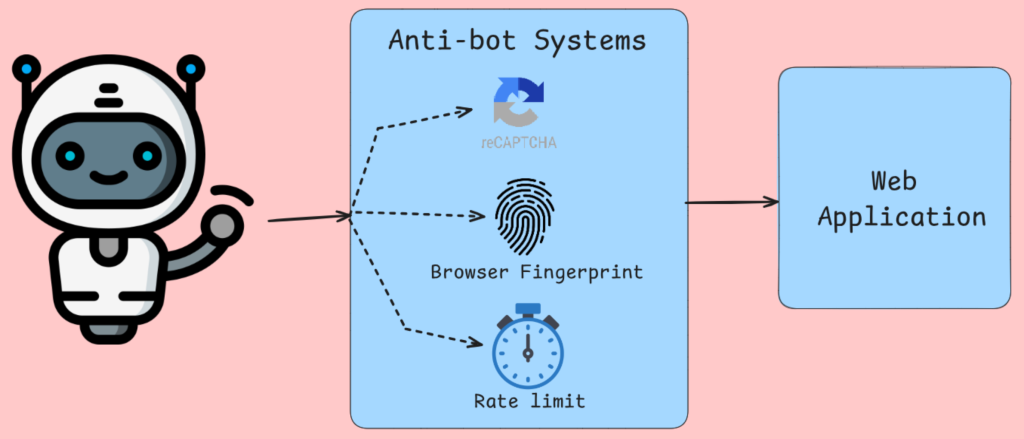

データ収集を破壊するボット対策システム

ボット検知は、IPブロック、ブラウザのフィンガープリントの分析、マウスの動き、その他のよく知られたチェックだけではありません。Cloudflareや同様のサービスのようなツールは、完了するためにブラウザの実行を必要とするJavaScriptの課題を注入します。ブラウザチェックの後、これらのテストに失敗したリクエストには代替コンテンツやエラーページが提供されます。スクレイパーは、正当なコンテンツの代わりに、CAPTCHAページ、アクセス拒否メッセージ、または意図的に誤解を招くデータを受け取ります。

レート制限アルゴリズムは、IPアドレス、ユーザーエージェント文字列などごとのリクエスト頻度を追跡します。この情報により、トラフィックが人間の行為と感じられる場合はトラフィックが制限されるかブロックされます。

サーバーサイド・レンダリングの問題

Next.jsのようなフレームワークを使ったサーバー上でのレンダリングは、異なる基準に基づいて異なるHTML出力を生成します。同じURLでも、スクレイパーがコントロールできなかったり、正確にシミュレートできなかったりする要因によって、まったく異なるコンテンツ構造を返すことがあります。パーソナライズされたコンテンツ、ジオフェンス情報、ユーザー固有の価格設定は、スクレイパーが意図したユーザーと異なるデータを見るシナリオを生み出します。

スクレイパーとオリジンサーバー間のキャッシュレイヤーは、最近更新されたコンテンツがCDNノードに伝搬するのに時間がかかるという時間的不整合をもたらします。スクレイパーは、古い商品価格、古い在庫状況、または現在のウェブサイトの状態を反映していないキャッシュされたエラーページを取得する可能性があります。地理的に異なる地域にあるエッジサーバーは、異なるキャッシュバージョンを提供することができるため、データの一貫性はどのサーバーがリクエストに応答するかに依存することになります。

ネットワークレベルのデータ破損

不安定なネットワーク接続、プロキシサーバーの問題、DNS解決の問題は、標準的なエラー処理では検出が難しい微妙なデータ破損を引き起こします。部分的なコンテンツのダウンロードは、パースには成功するものの、重要なページセクションを見逃す切り詰められたHTMLレスポンスを作成します。スクレイパーは商品一覧ページの最初の80%を受信し、正常に動作しているように見えますが、長いページの一番下にある読み込み項目が体系的に欠落している可能性があります。

圧縮アルゴリズムは、特に圧縮設定の異なるローテーションプロキシを使用している場合、送信中にデータを破損することがあります。

不正確なデータがアプリケーションに与える影響とは?

不正確なウェブスクレイピングデータは、ビジネスロジックやユーザーエクスペリエンスを根本的に損なう形でシステムに影響を与えます。これらの障害を理解することは、開発者がより回復力のあるデータパイプラインと検証レイヤーを構築するのに役立ちます。

分析パイプラインの劣化

データ品質の問題は、集計によって根本的なエラーが増幅される分析システムで最も顕著に現れます。スクレイピングされたeコマースの価格データにパースエラーが含まれ、通貨記号の処理に失敗して「29.99ドル」が「2999ドル」に変換されると、平均価格の計算が無意味になります。

スクレイピングされた商品識別子に目に見えないUnicode文字や末尾の空白が含まれていると、データベースの結合が知らないうちに失敗することがある。商品追跡システムでは、同じ商品が別々の項目として表示され、在庫数が膨らんだり、需要予測モデルが歪んだりする可能性がある。このような正規化の失敗は、ETLプロセスの至る所で発生し、下流のレポートが二重収益になる原因となる。

意思決定システムの失敗

スクレイピングされたデータに基づいて構築された自動意思決定システムは、入力の質が低下すると、致命的な間違った選択をする可能性がある。動的なウェブサイトからスクレイピングされた競合他社のデータに依存する価格監視アプリケーションは、実際の価格の代わりに「Loading…」やJavaScriptのエラーメッセージのようなプレースホルダ値をキャプチャすることがよくあります。これらの非数値文字列がバリデーションレイヤーをバイパスすると、価格設定アルゴリズムがデフォルトでゼロ値を設定する可能性があります。

レコメンデーションエンジンに取り組んでいる場合、ページネーションの問題や認証の障害により、特定の商品カテゴリーが体系的にキャプチャできない不完全なスクレイプデータセットに悩まされます。その結果、うまくスクレイピングされたカテゴリーへのレコメンデーションバイアスがエコーチェンバーを生み出し、多様な商品の顧客発見を減少させ、最終的に収益の成長と顧客満足度を制限します。

アプリケーションのパフォーマンス低下

スクレイピングされたデータを消費するアプリケーションは、データ品質の問題によって非効率的なデータベース操作が発生すると、パフォーマンスの問題を経験します。エスケープされていないHTMLタグを含むスクレイピングされたテキストフィールドは、検索インデックスを破壊し、最適化されたインデックス検索ではなく、テーブルのフルスキャンを引き起こす可能性があります。このようなパフォーマンス・ペナルティが複数の同時クエリにわたって蓄積されると、ユーザー向けの検索機能が応答しなくなる。

スクレイピングされたデータに一貫性のないフォーマットが含まれ、重複検出が不可能な場合、キャッシュ無効化戦略は失敗する。異なる時間にスクレイピングされた同じ製品情報が、さまざまな空白処理のために別々のキャッシュ・エントリとして表示され、メモリ使用量が増加し、キャッシュ・ヒット率が低下する可能性があります。このキャッシュ汚染により、アプリケーションは高価なデータベースを繰り返し呼び出すことになり、システム全体の応答性が低下する。

データ統合の問題

スクレイピングされたデータが単独で届くことはほとんどない。通常、内部データベースやサードパーティAPIと統合して、包括的なデータセットを作成する。ウェブサイトの再設計によってスクレイピングされたフィールド構造が予期せず変更されると、スキーマの不一致が一般的になる。商品カタログシステムは、スクレイピングロジックが新しいHTMLレイアウトに適応できず、下流のアプリケーションに不完全な商品情報を残し、検索結果や顧客の購買意思決定に影響を与えることで、重要な仕様を失う可能性がある。

データ鮮度の不整合により、スクレイピングされたデータが、関連する内部データと異なる期間を反映する状況が発生する。スクレイピングの遅延によって価格情報が取引タイムスタンプに遅れる場合、スクレイピングされた市場データと内部取引記録を組み合わせた金融アプリケーションは、誤ったポートフォリオ評価を生成する可能性がある。このような時間的不整合は、正確な監査経路を確立することを困難にする。

データ精度を向上させる様々な方法

ウェブスクレイピングにおけるデータ精度は、抽出パイプラインのさまざまな障害ポイントに対処するために連携する複数のテクニックの実装にかかっています。

ヘッドレス・ブラウザで動的コンテンツを扱う

従来のHTTPベースのスクレイパーは、多くのウェブサイトが最初のページロード後にコンテンツをレンダリングするためにJavaScriptに大きく依存しているため、データのかなりの部分を見落とします。PuppeteerやPlaywrightのようなヘッドレスブラウザは、通常のブラウザと同じようにJavaScriptを実行するため、動的に生成されるすべてのコンテンツを確実にキャプチャできます。

Puppeteerは、Chrome DevTools Protocolとの統合により、ページレンダリングの制御を提供します。特定のネットワークリクエストが完了するのを待ったり、DOMの変更を監視したり、コンテンツに入力するAPIコールを傍受することもできます。このアプローチは、最初のレンダリング後にAJAXリクエストでデータをロードするシングルページのアプリケーションで特に有用です。

ヘッドレスブラウザを使用する場合は、画像、CSS、および不要なプラグインを無効にして、メモリ消費量を減らし、ロード時間を改善します。画面サイズによってレンダリングされるコンテンツが異なるサイトがあるため、ビューポートサイズを適切に設定する。

ウェブサイト構造の変更に素早く対応

ウェブサイトの構造は頻繁に変化するため、固定の CSS セレクタや XPath 式に依存するスクレイパーは危険です。適応力のあるスクレイパーを構築するには、フォールバック戦略と、データ損失を引き起こす前に構造変化を検出する監視システムを実装する必要があります。

同じデータ要素を見つけるために複数のアプローチを試みるセレクタ階層を作成する。最も特殊なセレクタから始めて、徐々に一般的なセレクタにフォールバックする。

クラス AdaptiveSelector:

def __init__(self, selectors_list, element_name):

self.selectors = selectors_list

self.element_name = element_name

self.successful_index = 0

def extract_data(self, soup):

for i, selector in enumerate(self.selectors[self.successful_index:], self.successful_index):

elements = soup.select(セレクタ)

if elements:

self.successful_index = i

return [elem.get_text(strip=True) for elem in elements].

raise ValueError(f "No selector found for {self.element_name}")

# 使い方

price_selector = AdaptiveSelector([

'div.price-current .price-value', # 最も具体的なもの

'.price-current', # 中間値

'[class*="price"]' # 幅広いフォールバック

], 'product_price')ページ構造のフィンガープリントを経時的に比較する変更検出システムを実装する。

スクレイピングされたデータの検証とクリーニング

生のスクレイピングされたデータには、データの精度に影響を与える多くの不整合が含まれています。これを修正するには、包括的な検証とクリーニングのパイプラインを実装する必要があります。これにより、乱雑なウェブデータを、下流の処理に適した信頼性の高いデータセットに変換します。

データの検証は、型のチェックとフォーマットの検証から始まります。パースは通貨パターンと一致し、日付は正しくパースされ、数値フィールドには有効な数値が含まれていなければなりません。

インポート re

from datetime import datetime

from typing import Optional, Dict, Any

クラス DataValidator:

def __init__(self):

self.patterns = {

'price': re.compile(r'[♪$€£¥]?[♪d,]+.?♪d*')、

'email': re.compile(r'^[a-zA-Z0-9._%+-]+@[a-zA-Z0-9.-]+.[a-zA-Z]{2,}$'),

'phone': re.compile(r'^+?[ds-()]{10,}$'),

'date': re.compile(r'd{4}-d{2}-d{2}|d{2}/d{2}/d{4}')

}

def validate_record(self, record: Dict[str, Any]) -> Dict[str, Any]:

cleaned_record = {}。

for field, value in record.items():

if value is None or str(value).strip() == '':

cleaned_record[field] = None

続ける

cleaned_value = self._clean_field(field, str(value))

if self._is_valid_field(field, cleaned_value):

cleaned_record[field] = cleaned_value

else:

cleaned_record[field] = None

return cleaned_record

def _clean_field(self, field_name: str, value: str) -> str:

# 余分な空白を取り除く

cleaned = re.sub(r'˶'+', ' ', value.strip())

# ロジックをクリアする

cleanened を返す

def _is_valid_field(self, field_name: str, value: str) -> bool:

if 'price' in field_name.lower():

return bool(self.patterns['price'].match(value))

elif 'email' in field_name.lower():

return bool(self.patterns['email'].match(value))

# フィールド固有のバリデーションを追加する

return len(value) > 0スクレイピングエラーを示すかもしれない疑わしいデータポイントを特定するために、異常値検出を実装する。四分位範囲分析のような統計的手法は、価格や数量、その他の数値が予想される範囲から外れていることにフラグを立てるのに役立ちます。文字列の類似性アルゴリズムは、破損したテキストフィールドや抽出エラーを検出することができます。

エラー処理と再試行の実装

ネットワーク障害、サーバーエラー、パース例外はウェブスクレイピング操作では避けられません。包括的なエラーハンドリングを備えたウェブスクレイパーを構築することで、個々の障害が連鎖してスクレイパーが完全に故障するのを防ぐとともに、リトライメカニズムが一時的な問題を自動的に処理します。

指数関数的バックオフは、レート制限と一時的なサーバーの過負荷を処理するための効果的な戦略を提供します。短い遅延から開始し、その後の再試行の待ち時間を徐々に長くしていきます。このアプローチは、ボット対策を誘発する可能性のある攻撃的な再試行パターンを避けながら、サーバーに回復する時間を与えます。

インポート asyncio

インポート aiohttp

from typing import Optional, Callable

class ResilientScraper:

def __init__(self, max_attempts=3, base_delay=1.0):

self.max_attempts = max_attempts

self.base_delay = base_delay

self.session = なし

async def fetch_with_retry(self, url: str, parse_func: Callable) -> Optional[Any]:

for attempt in range(self.max_attempts):

try:

if attempt > 0:

delay = self.base_delay * (2 ** attempt)

await asyncio.sleep(delay)

responseとしてself.session.get(url)でasync:

if response.status == 200:

content = await response.text()

return parse_func(content)

elif response.status == 429: # レートが制限されている

続ける

elif response.status >= 500: # サーバーエラー

続ける

else: # クライアントエラー

リターン None

except (aiohttp.ClientError, asyncio.TimeoutError):

続ける

リターン Noneサーキットブレーカーパターンは、スクレイパーが失敗するサービスを圧倒するのを防ぎます。個々のドメインのエラー率を追跡し、許容できる閾値を超えるエラー率が発生した場合、リクエストを一時的に無効にします。このアプローチにより、スクレイパーとターゲットのウェブサイトの両方を障害時の不要な負荷から守ります。

ローテーションプロキシとユーザーエージェントの使用

IPブロッキングは、大規模ウェブスクレイピングにおいて最も一般的な障害の一つです。プロキシとユーザーエージェントをローテーションさせることで、異なる明白なソースにリクエストを分散させ、スクレイピングの速度を維持しながら検出を大幅に難しくします。

プロキシローテーションは、コネクションプールとリクエストの分散を注意深く管理する必要があります。同じドメインへの連続したリクエストに同じプロキシを使うことは避ける。その代わりに、プロキシプール全体で均等な分配を保証する ラウンドロビンかランダム選択のアルゴリズムを実装してください。

import random

from typing import リスト、ディクショナリ、オプション

class ProxyRotator:

def __init__(self, proxies: List[str], user_agents: List[str]):

self.proxies = proxies

self.user_agents = user_agents

self.failed_proxies = set()

def get_next_proxy_and_headers(self) -> tuple[Optional[str], Dict[str, str]]:

available_proxies = [p for p in self.proxies if p not in self.failed_proxies]: 利用可能なプロキシ。

if not available_proxies:

self.failed_proxies.clear()

available_proxies = self.proxies

プロキシ = random.choice(available_proxies)

user_agent = random.choice(self.user_agents)

ヘッダー = {

'User-Agent': user_agent、

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8'、

'Accept-Language': 'en-US,en;q=0.5'、

'Connection': 'keep-alive'

}

return プロキシ, ヘッダー

def mark_proxy_failed(self, proxy: str):

self.failed_proxies.add(proxy)ユーザーエージェントのローテーションは、ウェブ解析データに見られる現実的なブラウザの分布を模倣する必要があります。ユーザーエージェントリストは、実際の市場シェア統計に従って重み付けし、Chrome の亜種が一般的でないブラウザよりも頻繁に表示されるようにします。モバイルデバイスに異なるコンテンツを提供するサイトのために、モバイルユーザエージェントを含める。

AIによるプロキシ管理

データをスクレイピングする際、IP禁止は業務を完全に停止させる可能性のある課題です。旅行サイトでフライト価格をスクレイピングすることを考えると、ウェブサイトは同じIPアドレスから高速で複数のリクエストが来ていることを簡単に検出することができ、簡単にフラグを立て、スクレイパーを禁止することができます。

解決策は、基本的なプロキシのローテーションではなく、AIによるプロキシ管理にある。このアプローチでは、プロキシプールを使用してリクエストを異なるIPアドレスに分散し、身元を効果的に隠します。Bright Dataのようなプロフェッショナルサービスは、約195カ国から 1億5000万以上のレジデンシャルIPへのアクセスを提供しています。

インテリジェントなプロキシ管理は、いくつかの重要な利点を提供します。ウェブサイトが不審な行動を直接たどれないように匿名性を確保し、人間の行動を模倣してリクエスト頻度を調整する動的なレート制限を実装します。

これらの戦略は、複数のウェブ環境にわたってデータの正確性を維持するスクレイパーを作成するために連動します。ヘッドレスブラウザは完全なコンテンツをキャプチャし、アダプティブセレクタは構造的な変更を処理し、検証パイプラインは抽出されたデータをクリーニングし、包括的なエラー処理は失敗を防ぎ、AI駆動のプロキシ管理は配信を最適化します。

信頼性の高いスクレイピングのためのツールとベストプラクティス

適切なスクレイピングツールの選択は、対象ウェブサイトの複雑さとスケーラビリティ要件によって異なります。このセクションでは、ウェブスクレイピングにおけるさまざまな技術的課題に対応するツールの4つのカテゴリーについて検討します。

静的コンテンツ用Pythonライブラリ

Beautiful Soupは、最初のサーバーレスポンスでコンテンツが直接読み込まれるHTMLドキュメントのパースに優れています。このライブラリは、不正なHTMLを優雅に処理し、ネストされた要素からデータを抽出するための直感的なナビゲーションメソッドを提供します。Requestsは、多くのサイトが適切なデータアクセスのために必要とするサイトプロパティを処理するために、Beautiful Soupと自然にペアになる。

Scrapyは単純なライブラリではなく、完全なフレームワークとして動作する。組み込みのスケジューラによって同時リクエストを管理し、パイプラインアーキテクチャによって複雑なクロールシナリオを処理します。カスタムリクエスト処理、ユーザーエージェントのローテーション、自動再試行メカニズムにScrapyのミドルウェアシステムを使用することができます。

動的コンテンツのためのブラウザ自動化

SeleniumはWebDriverプロトコルを介して実際のブラウザを制御し、コンテンツレンダリングのためにJavaScriptの実行に大きく依存するウェブサイトに適しています。このツールは、フォームの送信、ボタンのクリック、追加コンテンツのロードをトリガーするスクロールページネーションのようなユーザーインタラクションを処理します。特定の要素が利用可能になるか、特定の条件を満たすまで実行を一時停止するには、待機条件を明示的に入力する必要がある。

Playwrightは、改善されたパフォーマンス特性と最新のウェブ機能に対するビルトイン処理で、同様のブラウザ自動化機能を提供します。このツールの自動待機機能は、インタラクションを続行する前に要素がアクション可能になるまで自動的に待機することにより、ほとんどのタイミングの問題を排除します。Playwrightのネットワーク傍受機能により、ページコンテンツに入力されるAPIコールを監視することができ、レンダリングされたHTMLをパースするよりも効率的なデータアクセスメソッドが明らかになることが多い。

ヘッドレスブラウザソリューション

Puppeteerは、特にChromiumベースのブラウザをターゲットとしており、DevTools Protocolとの統合により、ブラウザの動作をうまく制御することができる。このツールは、データ抽出と同時にスクリーンショット、PDF、パフォーマンスメトリクスの生成に優れています。画像やスタイルシートのような不要なリソースをブロックし、コンテンツにフォーカスした抽出のためのスクレイピング速度を向上させるために使用できるリクエストの遮断機能を備えている。

Playwrightはクロスブラウザ機能により、異なるレンダリングエンジン間でのスクレイピングに威力を発揮する。このツールのcodegen機能は、ユーザーのインタラクションを記録し、対応する自動化スクリプトを生成します。

企業向けプロキシ管理プラットフォーム

Bright Dataは、複数のページのスクレイピングセッションを通して一貫したIDを維持するセッション永続化機能で、世界各地のレジデンシャルIPローテーションを提供します。Web Unlocker サービスは、CAPTCHA 解決やブラウザフィンガープリントのランダム化など、一般的なボット対策を自動的に処理します。スクレイピング・ブラウザは、プロキシ・ローテーションと、検出を回避するために最適化された事前設定済みブラウザ・インスタンスを組み合わせます。

リクエスト管理とレート制限

バックオフ戦略を実装することで、一時的な失敗を優雅に処理しつつ、ターゲットサーバーを圧倒することを防ぐ。例えば、トップPython HTTPクライアントの1つであるurllib3は、試行間の遅延を設定できるリトライメカニズムを提供しています。トークンバケットアルゴリズムを使用したカスタムレート制限により、リクエスト間隔をサーバーの容量に合わせることができます。

セッション管理は、認証が必要なウェブサイトや、リクエスト間の状態を維持するウェブサイトにとって重要になります。永続的なクッキーの保存とヘッダー管理は、スクレイパーが長時間のスクレイピングセッションを通して保護されたコンテンツへのアクセスを維持することを保証します。接続プーリングは、同じドメインへの複数のリクエストにわたって確立されたネットワーク接続を再利用することにより、オーバーヘッドを削減します。

データ検証

Pydanticのようなスキーマ検証ライブラリは、データ構造の一貫性を強化し、処理パイプラインを通じて伝播する前にパースエラーを検出します。スクレイパーコンテンツのチェックサム検証を実装することで、ウェブサイトがその構造やコンテンツフォーマットを変更したときにそれを検出し、スクレイパー保守のためのアラートをトリガーすることができる。

これらのツールの選択は、特定の技術要件に依存します。例えば、静的コンテンツスクレイパーは、単純な抽出タスクに対して最高のパフォーマンスを提供し、ブラウザ自動化ツールは、リソースの消費を増加させる代償として、複雑なインタラクティブシナリオを処理します。

まとめ

この記事では、ウェブサイトからデータをスクレイピングする際に開発者が直面する課題について学び、次に悪いスクレイピングの結果を確認しました。そして最後に、この問題を解決するのに役立つツールや戦略について学んだ。